分子や材料やプロセスのデータを扱い、データ解析・機械学習をします。その結果、数理モデルが得られたり、数理モデルに基づいて新たな材料や分子や材料やプロセスを設計できたりします。

データ解析や機械学習で扱われるデータは、多くの場合、人が集めます。分析装置から得られるファイルからデータを抽出したり、実験ノート等からエクセルに転記したりします。もちろん、分析装置の精度等によってデータがばらつくことはありますが、分析結果や実験結果として事実がデータになっています。

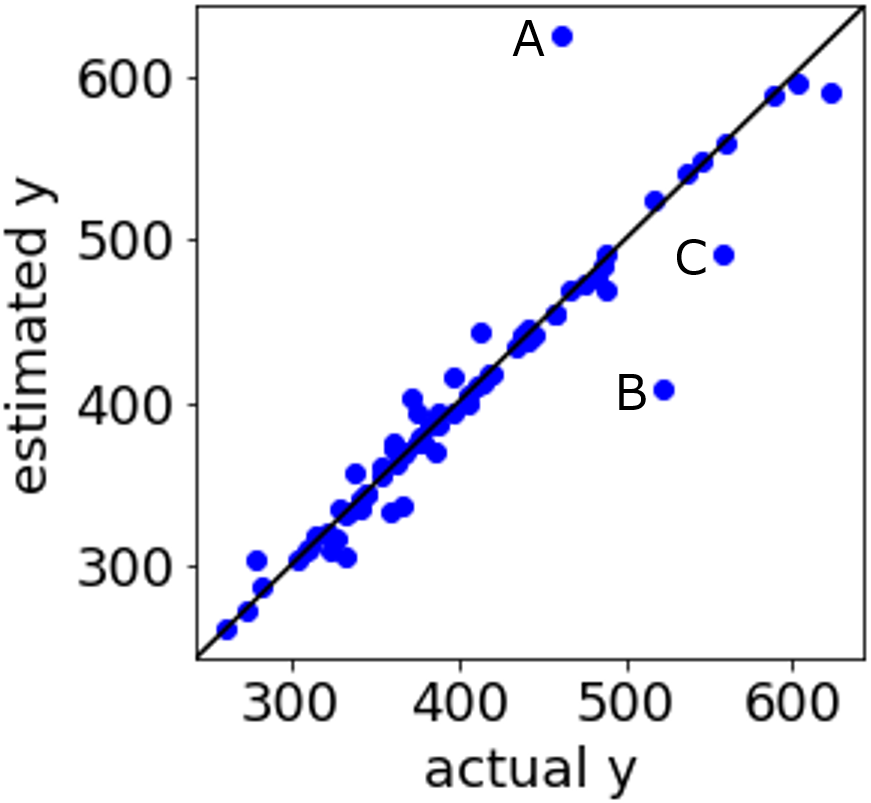

一方で、データをエクセル等にまとめたり、数式で変換したりするのは、自動化するプログラムを作ることも含めて、人がやります。エクセルでデータを整理するときに、数値や単語を間違えたり、入力する列・行を間違えたり、変換する数式を間違えたりすると、そのデータは嘘になります。また、扱うデータの中に嘘のデータはないとして、例えば分子記述子・合成条件・製造条件・プロセス条件・プロセス変数 x と材料の活性・物性・特性など y の間で数理モデル y = f(x) を構築するとき、例えばモデルがトレーニングデータに過度に適応してしまうオーバーフィッティングが起きた場合に、y の実測値と推定値が非常によく合って見えてしまうことがあります。これを「モデルの精度が高い」と解釈するのは、嘘になります。

以上のように、データ自体は実験前や実験後の事実を忠実に示しており嘘はつきませんが、基本的に人がデータを扱ったり、人がデータを解析したりするときに、意図していない単純なミスも含めて、嘘をつくことになります。嘘のデータを含むデータセットから得られた結果は信用できませんし、データから得られた結果を解釈して嘘をつくことは、その後の解析 (予測や逆解析など) の結果を信頼できないことになります。例えば、モデルを用いて誤差の小さい予測ができなかったり、逆解析の結果が全然当たらなかったりする原因の一つは、人がつく嘘になります。

データを扱うときやデータ解析・機械学習をするときは、データを使って人が嘘をつかないよう注意する必要があります。例えばデータ収集をなるべく自動化したり、データ整理に人のダブルチェックを入れたり、モデルを適切に検証したりする必要があります。

この辺り注意しながら、分子設計・材料設計・プロセス設計・プロセス管理を実施するようにしましょう。

以上です。

質問やコメントなどありましたら、twitter, facebook, メールなどでご連絡いただけるとうれしいです。