分子設計・材料設計・プロセス設計・プロセス管理において、分子記述子・実験条件・合成条件・製造条件・評価条件・プロセス条件・プロセス変数などの特徴量 x と分子・材料の物性・活性・特性や製品の品質などの目的変数 y との間で数理モデル y = f(x) を構築し、構築したモデルに x の値を入力して y の値を予測したり、y が目標値となる x の値を設計したりします。

モデルの予測精度を上げるためにサンプルを増やそうとか、サンプルを増やしてモデルの予測精度を向上させようとか、話すことがあると思います。もちろん、そのアプローチは正しいのですが、単に「サンプルが増えるとモデルの予測精度が向上する」だけでは、解像度がとても低く、深い議論をするには不十分です。ここでは、サンプルが増えることでモデルの予測精度が向上することを、解像度を上げて、考えてみます。

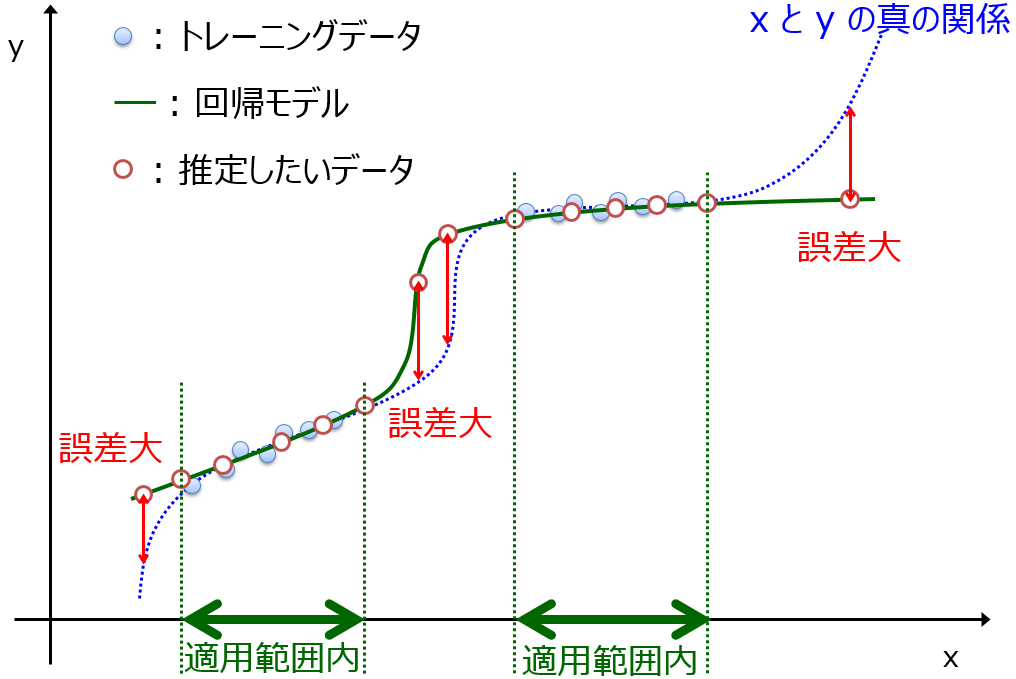

まず、サンプルが増えることでモデルの適用範囲が拡大します。

基本的に、機械学習モデルはトレーニングデータのサンプルの周辺のみを精度良く予測できます。サンプルが増えると、モデルが精度良く予測できる x のデータ領域が広がり、その結果、モデルの予測精度が向上すると言えます。

もう一つは、サンプルが増えることでモデルの予測精度の妥当な評価が可能になります。基本的にサンプルが少ない時には、ダブルクロスバリデーション (外側のクロスバリデーションは leave-one-out クロスバリデーション) でモデルを評価します。例えば 10 サンプルあるときは、9 サンプルでモデルを構築し、残りの 1 サンプルを予測することを 10 回繰り返します。これによりトレーニングデータとテストデータの両方の最大化ができます (トレーニングデータ 9 サンプル、テストデータ 10 サンプル)。しかし、最大化できるとはいえ、そもそもサンプルが少ない場合は、偶然の相関 (chance correlation) の影響を受けやすくなります。

その結果、ダブルクロスバリデーションによる予測結果が、実際の y の値と合わなかったり (予測精度が低くなったり)、本来は予測精度が低いにもかかわらず偶然に良い結果となった手法が選択されることになります。

サンプル数が例えば 30 に増えれば、ダブルクロスバリデーションにおいて 29 サンプルでモデルを構築することができ、構築されるモデルへの偶然の相関の影響が小さくなります。これにより、より妥当なモデルが構築され、残りの 1 サンプルを的確に予測できるようになります (これが 30 回繰り返され、30 サンプルでモデルの予測精度を評価できます)。

サンプルが増えることで、構築されるモデルが偶然の相関の影響を受けにくくなり、結果的に適切にモデルの予測精度を評価できるようになります。

以上のように、モデルの予測精度が向上することは、モデルの適用範囲が広がることと、偶然の相関の影響を受けにくくなり適切にモデルの予測精度を評価できることを意味します。サンプルを増やすことでは、これまで得られなかった x と y の間の未知の関係を抽出できるわけではありません。x と y の間の本質的な関係を獲得するためには、サンプルを増やすだけでなく、特徴量を工夫する必要があります。このように、モデルの予測精度の向上のためには、多角的に検討することが推奨されます。

以上です。

質問やコメントなどありましたら、X, facebook, メールなどでご連絡いただけるとうれしいです。