分子設計・材料設計・プロセス設計・プロセス管理において、分子記述子・実験条件・合成条件・製造条件・評価条件・プロセス条件・プロセス変数などの特徴量 x と分子・材料の物性・活性・特性や製品の品質などの目的変数 y との間で数理モデル y = f(x) を構築し、構築したモデルに x の値を入力して y の値を予測したり、y が目標値となる x の値を設計したりします。

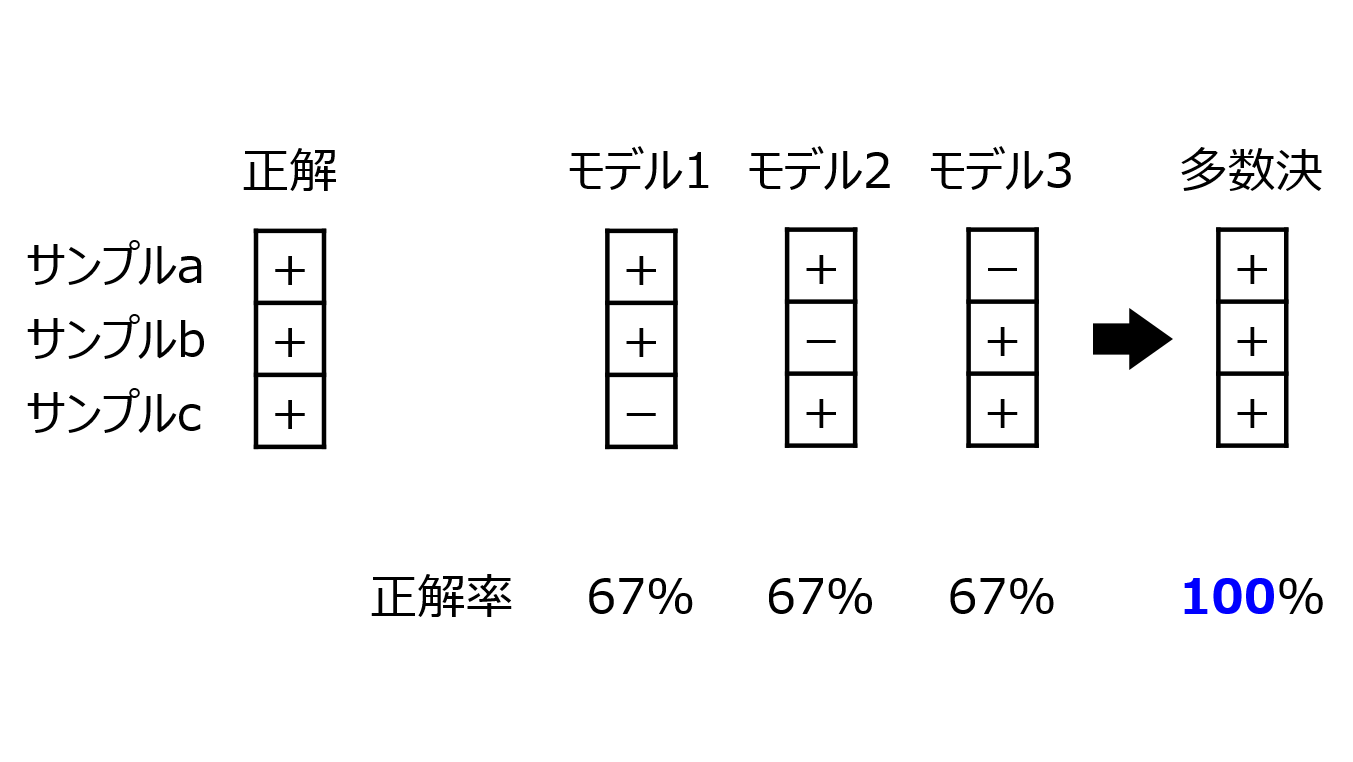

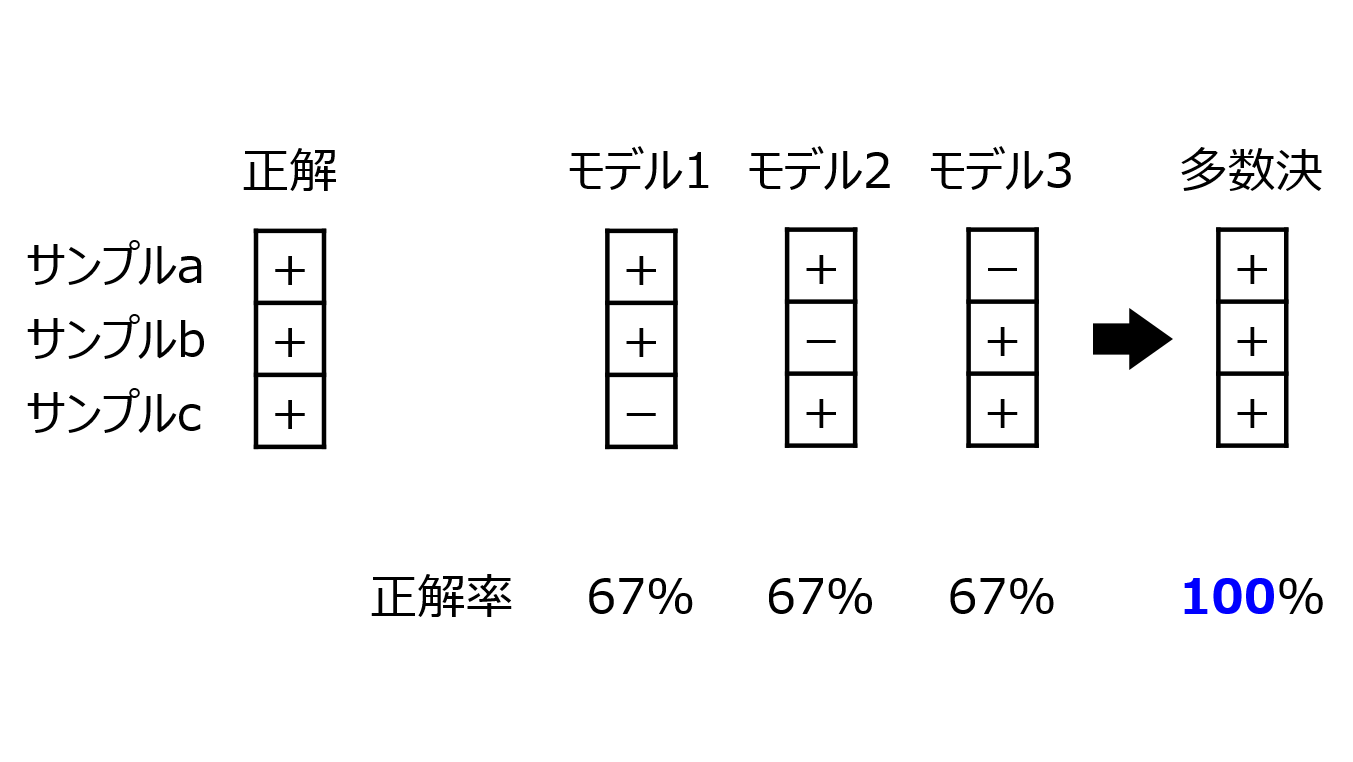

モデルの予測精度を向上させるために、アンサンブル学習をすることがあります。

アンサンブル学習をするとき、モデルをたくさん構築することになります。そのモデルの構築の仕方を工夫することで、アンサンブル学習の中でも、モデルの予測精度を向上できることがあります。例えば、Adaboost や勾配ブースティングです。

それぞれ、これまで構築したモデルでは説明できない y 情報を次のモデルで説明するように、新しいモデルを構築することで、最終的な予測精度が向上するようにしています。

今、お読みになっている研究者の中にも、自分なりの新たなアンサンブル学習法を提案・開発している方もいらっしゃると思います。

アンサンブル学習では、もちろんモデルをたくさん構築するのですが、モデルの予測精度を向上させることを考えた時に、どんなモデルでもよいわけではありません。アンサンブル学習における重要な点の一つとして、モデル間の独立性があります。極端な例をいえば、まったく同じモデルをいくつ集めても予測精度は向上しません。同様に、似ているモデルをたくさん集めたからといって、予測精度の向上にはほとんど寄与しません。それぞれのモデルが独立しているからこそ、一つ一つのモデルが、他のモデルにはない情報を反映させることで、全体としての予測制度が向上します。

例えば、各モデルの予測精度を高くするように構築して、それらを集めてアンサンブル学習する方法を考える人がいますが、一つ一つのモデルを構築するときに、それぞれのモデルの予測精度を、同様の方法で評価して向上させていたとしたら、予測精度の評価方法が同じであればその評価値が高い手法ということで、もちろん個別の予測精度は高いかもしれませんが、それらを合わせることによる さらなる予測精度の向上は、あまり期待できません。

アンサンブル学習におけるモデルを準備するときは、モデル間の独立性に注意するとよいでしょう。では、どのようにモデル間の独立性を考えるのがよいでしょうか。1つは、テストデータ、すなわちモデル構築に用いていない新たなサンプルにおける予測値の間の相関関係を確認します。例えば、モデル A でテストデータの y を予測した値と、モデル B でテストデータの y を予測した値との間の相関が低ければ、モデル間の関係性はあまりない (独立に近い) といえますし、相関が高ければ2つとも同じようなモデルで独立していないといえます。

モデル間の独立性を検証するために新たなサンプルを準備するのは大変かもしれませんが、アンサンブル学習を検討するときの1つの方法として参考にしていただければと思います。

以上です。

質問やコメントなどありましたら、X, facebook, メールなどでご連絡いただけるとうれしいです。