金子研の論文が Heliyon に掲載されましたので、ご紹介します。タイトルは

です。

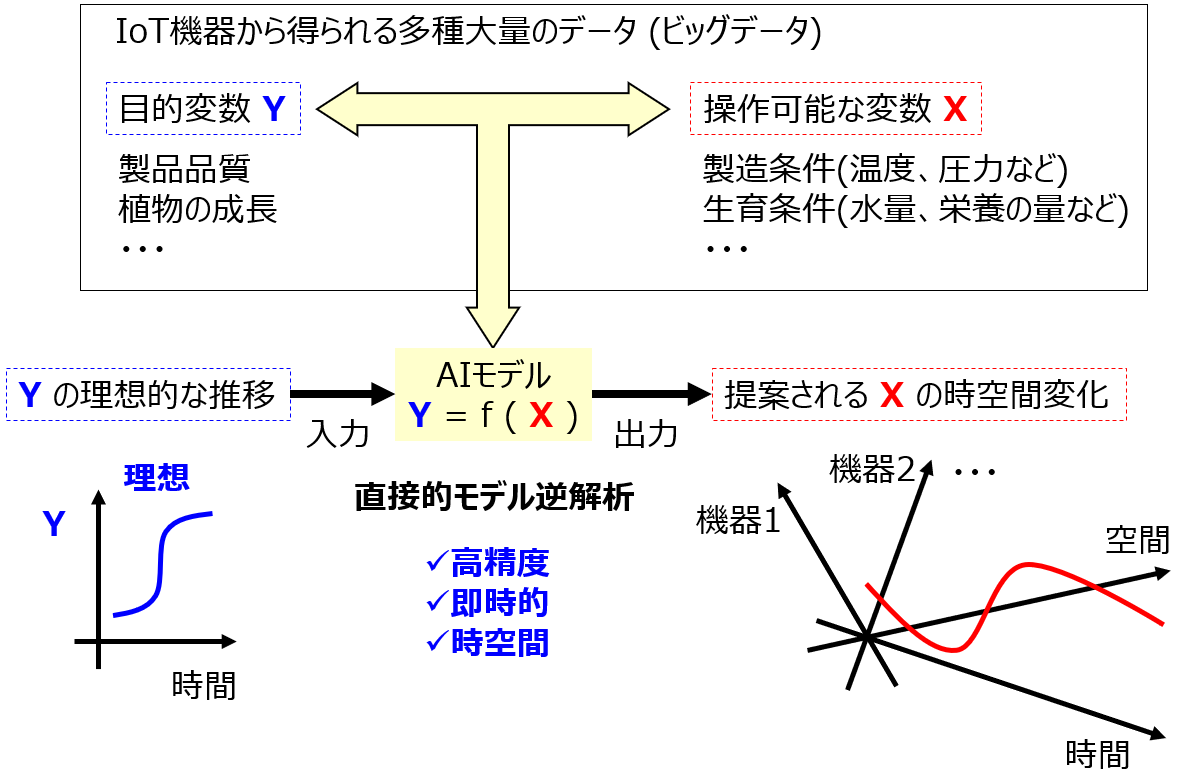

回帰モデルの予測精度を高めるため、そして回帰モデルを解釈しやすくするため、説明変数 x の特徴量を選択することが重要です。この研究では、特徴量選択手法 (変数選択手法) を適切に評価することを目的として、選択された x を用いて構築された回帰モデルの予測精度だけでなく、選択された x の数や、目的変数 y と関係のない特徴量の選択された数で、特徴量選択手法を議論することを提案します。

今回取り上げた特徴量選択手法は以下のとおりです。

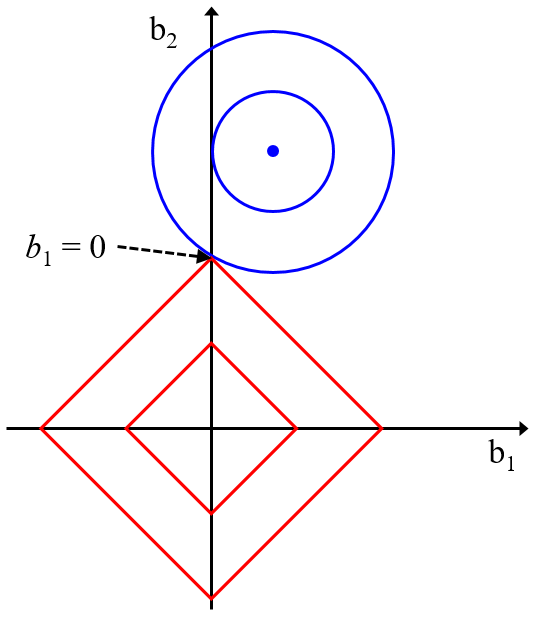

- Least Absolute Shrinkage and Selection Operator (LASSO)

- Genetic Algorithm-based Partial Least Squares (GAPLS)

- Genetic Algorithm-based Support Vector Regression (GASVR)

- Boruta

- r-Boruta

リッジ回帰(Ridge Regression, RR), Least Absolute Shrinkage and Selection Operator (LASSO), Elastic Net (EN)~誤差の二乗和と一緒に回帰係数の値も小さくする~

リッジ回帰(Ridge Regression, RR), Least Absolute Shrinkage and Selection Operator (LASSO), Elastic Net (EN) について、pdfとパワーポイントの...

GAPLS, GASVR でモデルの推定性能がよくなるように説明変数の選択をしよう![Pythonコードあり]

遺伝的アルゴリズム (Genetic Algorithm, GA) を使って説明変数を選択する話です。2つの手法である Genetic Algorithm-based Partial Least Squares (GAPLS) Geneti...

[解析結果付き] Boruta、ランダムフォレストの変数重要度に基づく変数選択手法

Boruta という、ランダムフォレスト (Random Forest, RF) の変数重要度に基づいた変数選択手法について、パワーポイントの資料とその pdf ファイルを作成しました。いろいろなデータセットを解析しましたが、モデルの推定性...

r-Boruta とは、Boruta におけるパーセンタイルの閾値を疑似相関に基づいて設定した手法です。

化合物のデータセットやスペクトルのデータセットを含む 8 つのデータセットを用いて特徴量選択をします。それぞれの特徴量選択手法の性能を、以下の 3 点で議論します。

- 選択された特徴量を用いたときの回帰モデルの予測誤差

- 元の特徴量に対する、選択されたオリジナルの特徴量の割合

- 元の特徴量に対する、選択された乱数の特徴量の割合

1. については、24 の回帰分析手法を用いて評価します。2. は、各特徴量選択手法で特徴量を選択したときの、元の特徴量に対する、選択された特徴量の割合です。3. については、元の特徴量と同じ数だけ乱数の特徴量を追加してから、各特徴量選択手法で特徴量を選択し、元の特徴量に対する、選択された乱数の特徴量の割合を調べます。

データ解析の結果、たとえば以下のことがわかりました。

- LASSO では選択されたオリジナルの特徴量と選択された乱数の変数がともに多く、Boruta ではともに少なく、GAPLS, GASVR, r-Boruta ではそれらの中間であった

- 選択された乱数の特徴量が多いからといって、回帰モデルの予測誤差が大きくなるとは限らない

- r-Boruta では、Boruta と比較して選択された乱数の特徴量が多くなったが、回帰モデルの予測誤差は小さい傾向があった

- 特徴量選択によりyと関係のない特徴量が選択されても、様々な回帰分析手法によりそのようなノイズの特徴量の影響を無視した良好な精度の回帰モデルが構築できた

- 特徴量選択では、yと関係のない特徴量が選択されてしまっても、yと関係のある特徴量が削除されないことが重要

興味のある方は、ぜひ論文をご覧いただければと思います。どうぞよろしくお願いいたします。

以上です。

質問やコメントなどありましたら、twitter, facebook, メールなどでご連絡いただけるとうれしいです。